AI Agent Index : une base de données inédite pour cartographier les agents d’Intelligence Artificielle…

Et mieux les comprendre

Des chercheurs du Massachusetts Institute of Technology (MIT) ont récemment lancé l’AI Agent Index, la première base de données publique dédiée à la documentation des systèmes d’IA agentique déployés et conçue pour centraliser et structurer l’information sur ces systèmes.

L’IA agentique (ou agent-based AI) désigne des systèmes capables de percevoir leur environnement, de raisonner sur les données reçues, de planifier et exécuter des tâches avec un minimum d’intervention humaine. Ces systèmes vont au-delà des algorithmes de machine learning traditionnels en intégrant des capacités telles que la gestion de mémoire, la planification multi-étapes et l’utilisation d’outils externes. Un exemple courant est celui des agents logiciels comme AutoGPT, un logiciel open-source capable de décomposer un objectif complexe en sous-tâches et d’interagir avec des interfaces logicielles pour les accomplir.

L’AI agent index

Alors que ces systèmes deviennent de plus en plus courants, il n’existait jusqu’à présent aucun cadre structuré pour suivre leur conception technique, leurs applications et leurs mesures de sécurité. L’AI Agent Index comble cette lacune et offre une ressource structurée permettant de mieux comprendre le paysage des agents d’IA, les domaines d’application et les pratiques de gestion de risques associées.

Il fournit des informations sur :

- Les composants techniques, y compris la mise en œuvre du raisonnement (l’architecture de raisonnement), la mémoire, l’utilisation d’outils et la capacité de planification.

- Les domaines d’application, tels que l’ingénierie logicielle, la recherche scientifique, la robotique et les tâches informatiques.

- Les pratiques de gestion des risques, couvrant les mesures de sécurité, les tests internes et les évaluations externes.

Actuellement, la base de données comprend 67 systèmes d’IA agentique, chacun documenté avec des profils détaillés appelés “cartes d’agent”, qui décrivent leurs fonctionnalités, applications et pratiques de sécurité.

Une typologie de catégorisation selon le degré d’autonomie

L’AI Agent Index classe les systèmes en fonction de leur niveau d’autonomie et de leur capacité de prise de décision :

- Agents de niveau inférieur (exécution guidée par l’humain) : Ces systèmes automatisent des tâches spécifiques mais fonctionnent sous des contraintes définies par des humains. Il s’agit par exemple d’assistants de codage comme GitHub Copilot.

- Agents de niveau intermédiaire (automatisation adaptative) : Ces systèmes démontrent une planification en plusieurs étapes et une adaptation contextuelle, souvent utilisés dans le développement logiciel, l’aide à la décision ou l’optimisation de flux de travail.

- Agents de niveau supérieur (vers l’autonomie) : Un petit nombre de systèmes s’approchent de l’autonomie totale, bien que cela reste largement théorique en raison des considérations techniques, éthiques et de sécurité. Ces systèmes expérimentaux visent une autonomie totale, seraient capables de formuler des objectifs, d’évaluer leurs actions, et de réviser leur stratégie.

Quels enseignements peut-on tirer de l’AI Agent Index ?

L’observation des données répertoriés dans l’AI Agent Index permet de tirer un certain nombre d’enseignements concernant les systèmes en déploiement. En voici les plus significatifs :

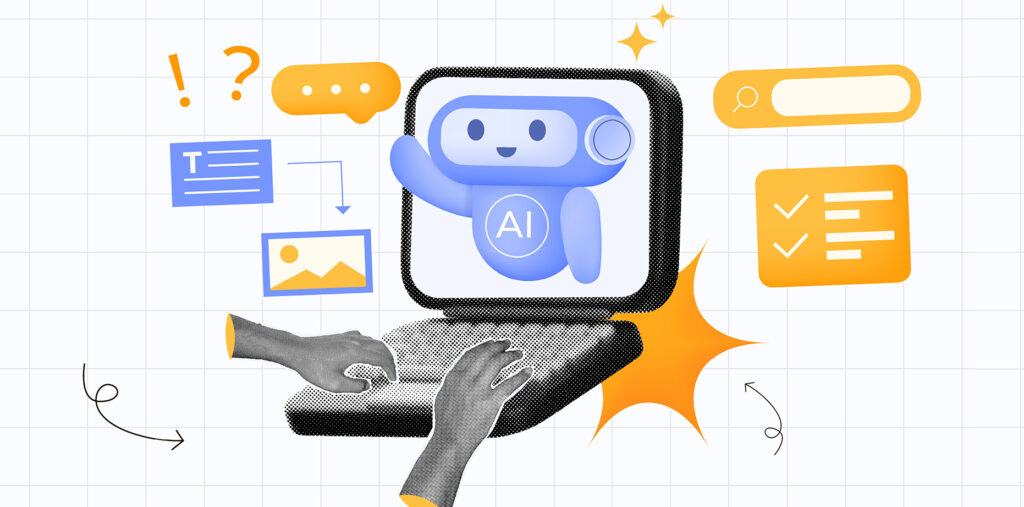

- L’adoption de l’IA agentique s’accélère : près de la moitié des systèmes répertoriés ont été déployés au cours du second semestre 2024.

- Il y a des domaines d’application dominants. La plupart des systèmes se concentrent sur l’ingénierie logicielle (debugging, génération de code, assistance à la conception) et les applications informatiques. Celles-ci sont réparties en six catégories : logiciel, utilisation informatique, universel, recherche scientifique, robotique et autres.

- Malgré cette accélération, la transparence en matière de sécurité reste limitée : seuls 19,4% des systèmes répertoriés divulguent publiquement une politique de sécurité formelle, et moins de 10% font état d’évaluations de sécurité externes.

Ainsi, premier en son genre, l’AI Agent Index constitue un outil de veille stratégique et de recherche intéressant, car il offre une vision d’ensemble inédite sur l’évolution rapide des agents d’intelligence artificielle. Cela permet aux chercheurs, ingénieurs et décideurs d’identifier les tendances émergentes, de comparer les architectures, et d’anticiper les défis liés à la généralisation de ces systèmes, notamment grâce aux informations techniques, applicatives et sécuritaires disponibles.

Malgré cela, l’Index démontre la difficulté réelle à mesurer et évaluer l’utilisation et les impacts de ces outils. Les informations et niveaux de détails présents sont divers, et l’index ne propose pas de métriques d’évaluation normalisées ni de données suivies concernant l’usage effectif des agents en contexte réel. Cela est le reflet des difficultés structurelles à avoir une vision fine et raisonnée des utilisations réelles de ces outils et de leur impact socio-économique.

Enfin, si l’Index offre une cartographie utile, il ne saurait se substituer à une analyse empirique approfondie des conditions de déploiement et d’usage de ces technologies dans des environnements opérationnels.

SOURCE