Concilier puissance de l’Intelligence Artificielle et impératif éthique : comment les Ressources Humaines se saisissent de l’enjeu

L’IA est entrée définitivement dans le monde de l’entreprise. Si certains dirigeants sont prêts à lui dérouler le tapis rouge, tous n’ont pas conscience des enjeux qu’elle engendre, dans le domaine technique mais aussi sur le facteur humain

Les données des salariés sont la matière première de l’IA et leur exploitation par des machines peut faire peur. L’opacité, réelle ou supposée, de la technologie et de ses résultats obligent à s'interroger sur la prise en compte de la dimension éthique

Les Ressources Humaines, à la fois consommatrices d’IA et garantes du bien-être des salariés, ont un rôle à jouer pour assurer l’équilibre entre la technologie et l’humain en définissant un cadre éthique propre à véhiculer les valeurs de l’entreprise

Nous baignons aujourd’hui dans un monde de données. Celles des autres et les nôtres ; celles confidentielles que seuls certains organismes sont habilités à connaître et à traiter ; celles personnelles qu’on nous demande dans un but précis ; celles que nous rendons publiques volontairement. Toutes constituent des sources d’informations particulièrement riches pour les entreprises.

Celles-ci les utilisent pour connaître nos goûts, dans des visées marketing ; nos opinions, dans un but électoral ; notre parcours, à des fins de recrutement ; notre entourage ; notre histoire… Cette collecte d’informations, si elle ne revêt pas toujours de mauvaises intentions, apparaît ainsi rarement désintéressée. Une certaine vigilance est donc de mise, à titre individuel et collectif, afin non seulement de rester maître de ce qu’on transmet et de ce qu’on donne à voir, mais aussi de l’utilisation que l’on peut en faire.

Depuis quelques années, l’introduction de l’intelligence artificielle dans l’exploitation de ces données a fait franchir un pas à ceux qui les utilisent mais aussi à ceux qui les fournissent. On peut désormais, grâce aux algorithmes et la quantité d’informations mis à leur disposition, non plus se contenter de connaître les événements présents ou passés mais anticiper l’avenir ou tout du moins prédire les comportements futurs et les faciliter, anticiper les besoins et y répondre en temps réel.

Si ces avancées peuvent nous faciliter la vie dans bien des cas, elles posent la question des restrictions qu’il faut imposer à l’utilisation des données personnelles. On peut déjà entrevoir les dangers que cette utilisation, en l’absence de réglementations, peut générer en termes de contrôle des actes voire de normalisation des comportements au niveau d’un pays. La Chine à cet égard, constitue un exemple frappant… et terrifiant ! Parmi les dispositifs mis en place là-bas, le « système de crédit social » est sans doute le plus fameux. Il vise à évaluer, en leur attribuant une note, l’ensemble des citoyens et des entreprises – chinois mais aussi étrangers – en fonction de leur attitude examinée au fil de l’analyse continue de leurs données.

Mais qu’en est-il dans la sphère professionnelle ? Dans quelle mesure les limitations réglementaires à l’utilisation des données personnelles existantes (CNIL, RGPD) sont-elles indispensables ? L’éthique doit-elle forcément passer par des règlements ? En quoi l’impératif éthique dans l’utilisation des données constitue-t-il un frein aux performances de l’intelligence artificielle ? Comment l’entreprise peut-elle concilier éthique et efficacité dans l’utilisation des données des salariés ?

Le recrutement : le process RH le plus consommateur d’IA encadré par une législation contraignant l’entreprise à une transparence vis-à-vis du candidat

Imaginons Thomas, 23 ans et laissons-le se présenter… « Je suis étudiant en fin de 2è année d’un Master de gestion à l’Université Paris 1. Je compte m’orienter vers le conseil lorsque j’aurai obtenu mon diplôme. J’ai déjà un CV bien rempli grâce aux différents stages que j’ai effectués. Mon année de césure passée en Australie a été également riche en expériences que j’ai pu valoriser sur mon CV mais aussi partager sur mon blog. Bien sûr, je suis très présent sur les réseaux sociaux… ».

Arrêtons-nous un instant pour faire le point sur la quantité d’informations que Thomas, avant même son entrée sur le marché du travail, a rendu disponible sur le net. Toutes ces données pourront être, et seront certainement, utilisées par ses futurs recruteurs. Elles leur permettront de connaître son cursus mais également ses centres d’intérêts, ses fréquentations… peut-être même ses dérapages, s’il n’a pas été assez prudent ou si l’entreprise est très curieuse.

A ce stade, nul besoin pour l’entreprise qui voudra recruter Thomas de recueillir son consentement pour utiliser ces informations : elles sont publiques et disponibles, Thomas a donné son accord en amont lorsqu’il les a mises sur le net. En revanche, lorsqu’il passera l’entretien de recrutement, l’entreprise devra se conformer à un article du Code du travail (L1221-8) stipulant que « le candidat à un emploi est expressément informé, préalablement à leur mise en œuvre, des méthodes et techniques d’aide au recrutement utilisées à son égard ». Les techniques évoquées incluent évidemment l’intelligence artificielle même si celle-ci est principalement utilisée, pour le moment, dans les premières phases du recrutement : rédaction des offres d’emploi, sourcing, mise en relation, présélection, et encore peu dans le choix ultime du candidat.

Le cas échéant, le recruteur devra, par exemple, informer Thomas de l’utilisation de l’IA pour rédiger l’offre à laquelle il a répondu. En effet, l’IA permet de créer des offres d’emploi qui, par le recours à de mots-clés et l’adoption du ton adéquat repérés par la technique du machine learning appelée « sentiment analysis », éveillent l’intérêt des candidats ciblés. D’aucuns pourraient parler ici de manipulation et, si le recruteur a effectivement utilisé cette pratique, l’on peut douter de sa totale transparence vis-à-vis du candidat sur le sujet. Le recruteur devra également, si c’est le cas, préciser à Thomas que son CV et sa lettre de motivation ont été « déchiffrés » par une IA pour en analyser le wording et ses connotations.

On voit donc que, en amont même de l’intégration d’un collaborateur, apparaît en creux la problématique de l’éthique, qui se manifeste ici dans la volonté du législateur de favoriser la transparence et de limiter l’asymétrie d’information entre recruteur et candidat. L’article du code du travail cité plus haut date de 2008. Il est complété de l’article L1221-9 précisant que « aucune information concernant personnellement un candidat à un emploi ne peut être collectée par un dispositif qui n’a pas été porté préalablement à sa connaissance ». Nul doute qu’aujourd’hui le recours croissant à l’IA dans le traitement des données personnelles en entreprise, rendent ces obligations encore plus pertinentes. On remarquera pourtant le paradoxe, voire l’ambiguïté, que contient le mot « préalablement » puisque le recruteur n’entre souvent en contact avec le candidat qu’après avoir collecté des informations sur lui…

Utilisation des données en question : la législation constitue-t-elle un obstacle à l’intelligence artificielle en entreprise ?

Reprenons le parcours professionnel de Thomas… Il a fait grosse impression auprès des trois personnes qui l’ont interviewé et une proposition de contrat vient de lui être faite. Lors de la signature de son contrat, on lui demandera de fournir un certain nombre d’informations et de documents : la copie de ses pièces d’identité, celle de son attestation d’affiliation à la Sécurité sociale, une copie de ses diplômes ou formations suivies. Si Thomas avait été de nationalité étrangère, une copie de son titre de séjour en cours de validité ainsi qu’une autorisation de travail, auraient également été demandées. Outre ces informations, nécessaires au respect d’une obligation légale, l’employeur peut collecter des informations utiles à la gestion administrative du personnel (par exemple, personnes à prévenir en cas d’urgence), à l’organisation du travail (photographie facultative de l’employé pour les annuaires internes et organigrammes), à l’action sociale prise en charge par l’employeur (comme les informations concernant les ayants droit de l’employé).

L’employeur pourra également exploiter toutes les informations transmises par Thomas sur son CV et lors des entretiens de recrutement. Le service RH aura ainsi la possibilité d’alimenter son référentiel de compétences, et au-delà, de collecter des informations sur les centres d’intérêt de Thomas, ses goûts, les sports qu’il pratique… Autant de données qui permettent d’identifier les fameuses « soft skills » du candidat.

Rien de très intrusif à ce stade me direz-vous. Et pourtant la CNIL impose à l’employeur qu’il garantisse un accès limité et contrôlé à ces données. Seules les personnes chargées de la gestion du personnel peuvent consulter les informations des collaborateurs. Les supérieurs hiérarchiques et les instances représentatives du personnel auront accès à certaines d’entre elles si elles sont nécessaires à l’exercice de leurs missions. Une traçabilité des accès et des modifications de ces données doit être mise en place par l’employeur. Le salarié doit par ailleurs être informé de l’identité des personnes qui y accèdent, des objectifs poursuivis par cette collecte, de la base légale du dispositif, du caractère obligatoire ou facultatif des réponses et de la durée de conservation des données.

Et l’IA dans tout ça ? Eh bien, elle se réjouit de ce volume de données puisqu’elle s’en nourrit et ne peut être efficace que s’il est élevé. C’est alors que la réglementation intervient. En effet, la RGPD introduit plusieurs principes et obligations :

- Minimisation des données à caractère personnel qui impose aux entreprises de s’interroger sur la nécessité des données collectées

- « Privacy by design » dont l’objectif est de préserver la vie privée, dès la conception du traitement d’IA, par des mesures techniques et organisationnelles

- Transparence et loyauté vis-à-vis des salariés afin de faire primer leurs intérêts sur ceux de l’employeur

- Analyse d’impact sur la vie privée avant la mise en place de tout projet d’IA nécessitant la collecte massive de données personnelles voire sensibles.

On peut dès lors se poser la question de la compatibilité de l’Intelligence Artificielle, qui ne fonctionne qu’avec des quantités immenses de données, avec la RGPD ou plus généralement avec toute réglementation visant à limiter non seulement l’utilisation mais aussi le volume de ces données. L’impératif éthique que véhiculent ces réglementations briderait-t-il nécessairement l’efficacité de l’Intelligence Artificielle ?

La question est légitime car les objectifs des premières semblent aller à l’encontre des moyens nécessaires à l’IA. Les règlements et l’éthique imposent non seulement la limitation des données en nombre, en nature et en durée, comme vu précédemment, mais prônent également des logiques collectives sur lesquelles reposent nos sociétés (pluralisme démocratique et culturel, mutualisation du risque). L’IA, à l’inverse, mise sur la personnalisation et l’individualisation pour donner des résultats les plus précis et ciblés possible. Quand l’éthique plaide pour la responsabilisation des humains dans la prise de décisions, les jugements et les évaluations, l’IA prévoit une délégation, partielle pour le moment, de ces tâches à la machine. Une attitude critique, la prise du recul, le libre-arbitre devraient, selon une démarche éthique, rester l’apanage des humains. Or, les performances de l’IA sont basées en grande partie sur l’autonomie des machines !

Toutefois, en matière de protection des données, les thuriféraires de l’intelligence artificielle objecteront qu’elle peut améliorer leur sécurisation et accès à travers, par exemple, l’évaluation quantitative des risques encourus sur un réseau, la détection des failles potentielles du réseau, l’identification de programmes malveillants, indésirables ou encore la protection contre les cyberattaques. Les solutions d’intelligence artificielle peuvent également faciliter le traitement en lui-même des données personnelles, comme la minimisation des données, l’établissement de cartographies précises des données, l’identification des données sensibles… A ce titre, l’IA peut interdire la saisie de certains termes dans les applications d’entreprise, permettant d’éviter en amont l’enregistrement dans une base de données d’informations à caractère sensible, dont le traitement est prohibé par le Règlement Général sur la Protection des Données.

On voit là le paradoxe de l’IA : des réglementations sont mises en place pour encadrer voire limiter son utilisation, et c’est elle qui peut permettre ou tout du moins faciliter leur application ! Une fois cette application effective et les données rendues conformes à ces réglementations, éventuellement grâce à l’IA, celle-ci peut les utiliser car leur volume reste conséquent.

Les biais des algorithmes de l’IA : être conscient de leur existence et de leurs conséquences pour pouvoir les réduire

Mais continuons à dérouler la carrière de Thomas… A la date anniversaire de son entrée dans l’entreprise, il sera convié à un entretien d’évaluation. Là encore, quantités de données le concernant vont être échangées entre lui, son manager et l’équipe RH. La digitalisation croissante de ce processus requiert les mêmes précautions dans la sécurisation de ces données et leur accès.

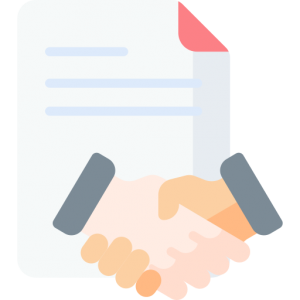

Au-delà du caractère sensible de ces informations, les méthodes utilisées pour l’évaluation, qui peuvent toutes être sujet à caution, le sont doublement lorsqu’elles font appel à l’IA. En effet, des biais statistiques et des biais cognitifs peuvent être reproduits par les algorithmes sur lesquels le recrutement ou l’évaluation automatisés s’appuient.

©Artimon Perspectives

Les premiers, appelés également biais de traitement, sont liés aux données sur lesquelles se base l’algorithme pour faire son auto-apprentissage. Si l’échantillon de données utilisé n’est pas représentatif de l’objectif à atteindre, alors les résultats de l’IA ne seront pas obtenus, ils seront faussés voire discriminants. Au contraire, plus insidieux, si l’échantillon de données est représentatif des pratiques historiques de l’entreprise, pas toujours exemplaires, cela peut conduire le traitement algorithmique à reproduire les erreurs du passé. Tout le monde a en tête l’expérience d’Amazon qui, en 2015, s’était servi d’une IA pour trier les CV des candidats, leur affectant une note de 1 à 5. Un an après, Amazon s’est aperçu que les femmes postulant à des emplois techniques étaient systématiquement écartées car moins bien notées. Ce résultat était lié à la manière dont a été conçue l’IA. Entraînée avec des profils de personnes recrutées entre 2004 et 2014, qui étaient majoritairement des hommes, elle en a conclu que sélectionner des candidats mâles était préférable.

Parmi les biais de traitement, on trouve également le biais de variable omise. Cette situation apparaît lorsqu’une variable qui peut être essentielle, n’est pas disponible et ne peut donc pas être exploitée par les algorithmes. Dans le cadre de recrutements ou d’évaluation, les soft kills font partie de ces variables omises difficiles à codifier et à incorporer dans les algorithmes. Il s’agit de capacités telles que le leadership, le travail en équipe ou l’intelligence émotionnelle. Autant d’atouts nécessaires pour monter une équipe performante mais qui pourraient ne pas être valorisés et ainsi pénaliser les personnes en disposant.

Les seconds biais, dits cognitifs, sont directement issus de notre manière de penser, de nos croyances et précisément de celles des développeurs des algorithmes ! Ceux-ci pourront en effet avoir tendance à suivre des modélisations populaires, à favoriser leur vision du monde, à déceler des corrélations illusoires sans s’assurer de la cohérence, de la fiabilité ou de la neutralité des résultats.

Un des biais cognitifs prégnant lors des recrutements est le biais de stéréotype, largement répandu chez les humains et reproduit par l’Intelligence artificielle grâce au machine learning et la technique du « word embedded ». Les moteurs de recherche proposent des associations automatiques de mots sur la base de nombreuses occurrences rencontrées dans les textes sur Internet. Par exemple, les biais de stéréotype peuvent se retrouver dans l’analyse textuelle des associations de mots liées aux métiers et au genre : le mot « femme » étant systématiquement associé à des termes tels que « femme de ménage », « nourrice », « réceptionniste », « styliste », ou bien « coiffeuse », tandis que le mot « homme » est associé à « chef », « philosophe », « capitaine », « financier ». On voit bien là aussi les risques de discrimination que ces biais peuvent générer : sexisme sur l’exemple précédent mais aussi racisme, discrimination sociale….

Une des parades dont disposerait la Direction, en lien avec les DRH, tient dans la transversalité des disciplines auxquelles elle pourrait faire appel lors de la mise en œuvre des solutions basées sur l’IA. Cette approche pluridisciplinaire réunissant data-scientistes, juristes mais aussi sociologues, psychologues, linguistes, bien qu’insuffisamment appliquée actuellement, serait nécessaire pour identifier, comprendre et limiter ces biais algorithmiques, issus, on l’a vu, de ceux des humains.

Inversement, ces biais étant initialement humains – les discriminations à l’embauche sont bien antérieures à l’utilisation des algorithmes ! -, on peut penser que la puissance de l’intelligence artificielle est propice à leur détection et à leur limitation. Analyser les données fournies aux algorithmes pour déceler leur manque de diversité, aider les recruteurs à se détacher des « profils types » vers lesquels ils se tournent habituellement grâce à des algorithmes qui partent des compétences réelles et non plus seulement des lignes sur un CV… Autant de possibilités offertes par l’IA et dont l’entreprise doit profiter pour rendre sa gestion des ressources humaines plus efficace et plus juste.

Le rôle de l’Intelligence Artificielle dans la GPEC : rendre les données exploitables avant de devenir un outil d’aide à la décision

Reprenons le parcours professionnel de Thomas… Au bout de trois ou quatre ans, estimant « avoir fait le tour de son poste » comme il l’a confié à sa DRH, il souhaite évoluer vers une autre fonction et demande sa mobilité. L’intelligence artificielle pourra ici aussi être utilisée et elle aura de quoi se nourrir avec l’ensemble des données collectées par l’entreprise depuis l’arrivée de Thomas : compétences acquises lors de formations, savoir-faire développés sur le terrain, qualités relationnelles…

En matière de gestion de carrière, le « matching prédictif » permet, par exemple, d’identifier les opportunités de promotion interne. L’employeur pourra sélectionner le profil du salarié qui a obtenu le meilleur score en fonction d’une liste de compétences nécessaires au poste convoité.

©Artimon Perspectives

Le « matching prédictif » peut aussi permettre de prédéterminer les évolutions de carrière en fonction de l’historique du salarié, qu’il comparera à celui des personnes ayant réussi dans tel ou tel poste. Pour autant, au vu des réponses des responsables de Ressources humaines, nous n’en sommes pas encore là car les DRH disposent de très peu d’indicateurs sur les mobilités, notamment sur les mobilités réussies, leurs natures, les compétences et le parcours des salariés concernés. Or comment faire de la prédiction basée sur des correspondances si les éléments à comparer ne sont pas disponibles.

La première étape consiste donc à rendre ces données accessibles et exploitables. Et c’est là peut-être le rôle initial de l’intelligence artificielle dans le domaine des RH. En effet, l’IA et les outils qui l’utilisent peuvent se révéler très efficaces pour consolider les données existantes, faire communiquer les différentes briques (référentiels des métiers et compétences, cartographie des emplois existants, évaluations des compétences…) et mettre en place un écosystème permettant de piloter la GPEC dans toutes ses composantes. Les bénéfices seront d’autant plus grands que cet écosystème sera pensé pour et avec les collaborateurs, non seulement pour afficher une certaine transparence à l’égard de l’utilisation de ces outils et lever ainsi la méfiance et les résistances des utilisateurs, mais aussi pour créer une véritable expérience collaborateur utile à tous.

—-

Dans le domaine des ressources humaines, les potentialités de l’intelligence artificielles sont réelles, vastes et multiples, même si elles ne sont, pour l’heure, pas toutes exploitées, ni présentes dans tous les process. On constate également qu’en matière d’éthique, l’IA constitue à la fois un risque mais également une opportunité. Sa puissance fait d’elle un outil efficace voire, à terme, incontournable dans le traitement de la donnée. Mais « un grand pouvoir implique de grandes responsabilités » (comme dirait Peter Parker…).

C’est pourquoi, si l’ensemble de l’entreprise est concerné par son utilisation, les DRH ont spécialement un rôle à jouer dans la définition du cadre éthique en cohérence avec les valeurs de l’entreprise. La conciliation des intelligences artificielles et humaines, est en partie de leur ressort, afin que chacune se complète et se perfectionne mutuellement. Mais la principale responsabilité des gestionnaires des ressources humaines réside dans l’accompagnement des parties prenantes, pour lever la défiance vis-à-vis d’une technologie qui peut être vue comme opaque voire dangereuse quant aux décisions qu’elle suggèrerait, et faciliter son adoption en associant l’ensemble des collaborateurs à la mise en œuvre des solutions qui l’utilisent.

C’est en effet en mobilisant le plus de personnes, de compétences, de disciplines et d’horizons différents que pourra être mis en place une Intelligence Artificielle toujours efficace mais plus éthique et soucieuse des valeurs que souhaitent véhiculer les législateurs, mais également l’entreprise.

Sources

- Comment permettre à l’homme de garder la main ? (PDF), CNIL, 2017

- L’Intelligence Artificielle s’invite dans les entretiens d’embauche – Géraldine, INASOFT, 2019

- Quel est le rôle de l’IA dans le recrutement ? – Muriel T, Talents Finance, 2020

- RGPD et Intelligence Artificielle : quel(s) impact(s) mutuel(s) ? – Business Services, 2019

- Etat des lieux et prospective : l’IA dans le recrutement – APEC, 2020

- Intelligence artificielle et RGPD peuvent-ils cohabiter ? Tribune de Eric A. Caprioli, avocat à la Cour, docteur en droit, et Isabelle Cantero, avocat associé Caprioli & Associés, L’Usine Digitale, 2020

- Mobilis in mobili: mieux comprendre la mobilité pour réinventer la gestion de carrières (PDF), Le Lab RH, 2019