L’intégration de l’IA dans la prise de décision: quelles évolutions du sentiment d’agentivité et quels enjeux ?

- L’intégration croissante de l’IA dans les processus décisionnels peut altérer le sentiment d’agentivité, c’est-à-dire la perception d’être à l’origine de ses choix et de se sentir responsables des conséquences de ses actions.

- Cette baisse d’agentivité peut avoir plusieurs conséquences comme le biais d’automatisation, la perte de responsabilité ou un manque d’acceptabilité des systèmes d’IA.

- Plusieurs travaux proposent des pistes pour atténuer la diminution du sentiment d’agentivité dans les interactions avec l’IA : des solutions techniques, comme l’explicabilité des modèles, visant à rendre les décisions plus compréhensibles ; et des approches centrées sur l’utilisateur, encourageant un rôle actif de l’opérateur dans l’interaction.

L’Intelligence Artificielle occupe une place croissante dans nos vies, avec des domaines d’applications aussi variés que la santé, la finance, les transports ou encore les médias. Les algorithmes d’IA, en exploitant de vastes quantités de données, permettent d’optimiser la prise de décision dans divers contextes, qu’il s’agisse de recommander des contenus numériques, d’assister les professionnels de santé dans l’établissement de diagnostics ou de participer à la sélection de candidatures lors de recrutements. Si ces avancées permettent d’accélérer et d’optimiser les processus décisionnels, elles interrogent néanmoins la place de l’humain dans ces interactions.

En déléguant certaines tâches à l’IA, l’utilisateur peut voir son implication évoluer, parfois jusqu’à se sentir moins à l’origine des décisions prises avec l’aide de ces systèmes. Ce phénomène renvoie à la notion de sentiment d’agentivité, qui désigne la perception d’être à l’origine de ses actions et d’en assumer les conséquences. Or, ce sentiment joue un rôle fondamental dans la cognition humaine, car il influence non seulement l’engagement dans l’action, mais aussi la perception de responsabilité et la prise de décision.

L’intégration croissante de l’IA dans nos processus décisionnels peut de cette manière transformer notre rapport à l’action et à la responsabilité. Comment l’automatisation influence-t-elle notre capacité à nous percevoir comme les initiateurs de nos choix ? Quels sont les effets d’une baisse d’agentivité sur l’acceptation et l’utilisation de ces systèmes ? Enfin, quelles pistes existent pour préserver un équilibre entre assistance technologique et contrôle humain ? Cet article explore ces transformations et leurs implications, en mettant en lumière les enjeux cognitifs, éthiques et sociétaux liés à l’agentivité dans un monde de plus en plus automatisé.

Le sentiment d’agentivité

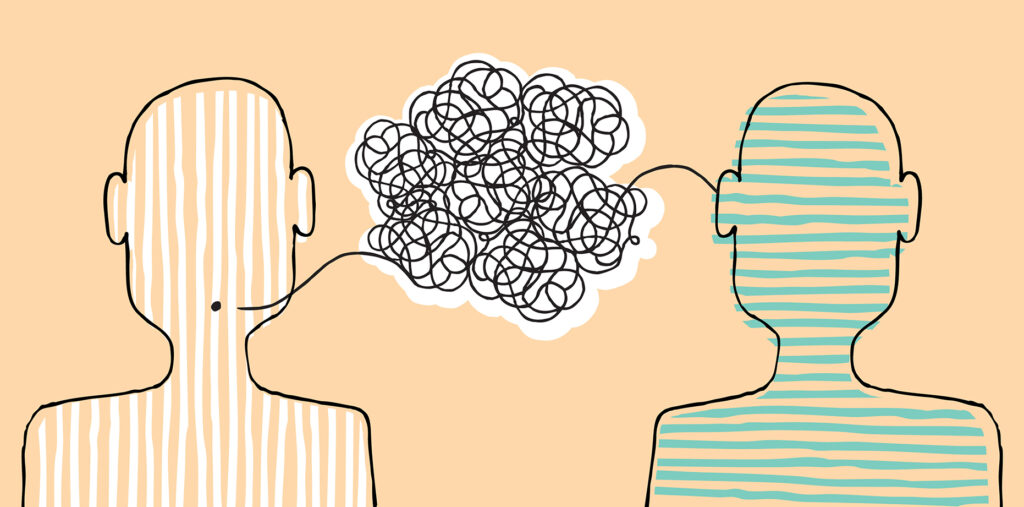

Le sentiment d’agentivité permet aux individus de ressentir leurs décisions comme découlant de leur propre volonté et d’assumer les conséquences de leurs actions. En règle générale, un individu établit un lien cohérent entre son intention, l’action qu’il entreprend et les effets qui en résultent (Fig. 1).

Selon Haggard et Chambon (2012), ce sentiment repose sur deux processus principaux :

- Processus rétrospectifs : Ils consistent à comparer les effets réels de nos actions avec les effets anticipés. Une correspondance étroite entre les prédictions du système moteur et les résultats observés renforce notre sentiment d’agentivité.

- Processus prospectifs : Moins étudiés, ces processus interviennent lors de la sélection de l’action, avant son exécution. La fluidité avec laquelle nous sélectionnons une action influence notre sentiment d’agentivité : une sélection d’action fluide est associée à un sentiment d’agentivité plus fort, indépendamment du résultat de l’action.

Ainsi, pour que le sentiment d’agentivité s’élabore correctement, il est essentiel que ces deux processus fonctionnent harmonieusement. Toute perturbation, qu’elle provienne d’une discordance entre l’action prévue et son effet réel, ou d’une difficulté lors de la sélection de l’action, peut altérer notre sentiment d’être à l’origine de nos actions (Fig. 2).

Le schéma causal reliant intention, action et effet peut être perturbé lorsque l’opérateur humain interagit avec une technologie comme l’IA. Par exemple, lorsqu’un utilisateur suit une recommandation algorithmique sans en questionner le fondement ou la véracité, l’action entreprise peut facilement être perçue comme étant initiée par le système plutôt que par l’individu lui-même. Cette forme de délégation peut instaurer une distance entre l’intention initiale et l’acte réalisé, affaiblissant ainsi le sentiment d’agentivité. En automatisant certaines tâches ou en influençant les choix à travers des recommandations, ces systèmes peuvent progressivement réduire l’implication des individus, limitant ainsi leur ressenti de contrôle, et leur sentiment d’agentivité. En particulier, une étude de Berberian et al. (2012) a montré dans une tâche de pilotage que, plus le niveau d’automatisation était élevé, plus le sentiment d’agentivité des participants diminuait. En effet, lorsque les participants bénéficiaient d’une assistance s’apparentant à un pilote automatique, ils se sentaient moins à l’origine des actions effectuées.

Ainsi, lorsqu’un individu interagit avec un système fortement automatisé, son rôle dans la prise de décision peut lui sembler moins évident, ce qui peut le conduire à adopter une posture plus passive et à se percevoir davantage comme un observateur que comme un acteur. Ce phénomène, connu sous le nom de « sortie de boucle de contrôle » (« Out-of-the-loop », Endsley, 1995), est particulièrement préoccupant dans les interactions avec l’IA. Si l’individu ne se considère plus comme l’initiateur de l’action, sa capacité à assumer la responsabilité des décisions prises en interaction avec l’IA s’en trouve fragilisée. Dans des domaines où les décisions assistées par ces technologies peuvent avoir des répercussions significatives sur la vie d’autrui, comme la médecine, la justice ou encore la finance, cette diminution du sentiment d’agentivité soulève des enjeux éthiques et sociétaux, et des questions se posent quant à l’encadrement et la conception de ces systèmes.

Quels sont les enjeux d’une baisse du sentiment d’agentivité ?

Si l’adoption croissante des technologies améliore l’efficacité et la précision des processus, elle influence également la manière dont les utilisateurs perçoivent et assument leurs décisions et actions. Une diminution du sentiment d’agentivité lors de l’interaction entre un opérateur humain et une IA peut entraîner plusieurs conséquences, notamment une baisse de l’engagement de l’opérateur dans les tâches qu’il accomplit, une incertitude quant à la répartition des responsabilités liées aux actions effectuées, ainsi qu’un impact négatif sur l’acceptabilité des technologies et in fine leur intégration dans la société.

Biais d’automatisation

L’un des premiers effets de l’automatisation sur la prise de décision est une réduction de l’implication active de l’utilisateur. Lorsque les algorithmes formulent des recommandations, les individus peuvent avoir tendance à les suivre sans réellement les questionner. Ce phénomène, connu sous le nom de biais d’automatisation (Skitka, Mosier, & Burdick, 1996), a été observé dans plusieurs domaines, notamment en médecine, où les professionnels font parfois une confiance excessive aux systèmes automatisés, au détriment de leur propre évaluation. Goddard et al. (2012) ont montré que ce biais réduit la capacité des utilisateurs à détecter les erreurs des algorithmes : en supposant que les décisions automatisées sont fiables, les opérateurs effectuent moins de vérifications, ce qui peut compromettre la qualité des décisions et diminuer leur engagement dans la tâche.

Cette diminution de l’engagement ne se limite pas à une simple perte d’attention, elle est aussi étroitement liée au sentiment d’agentivité. En effet, des études en interaction humain-machine montrent qu’une baisse du contrôle perçu sur une tâche entraîne une forme de désengagement cognitif et comportemental (Mulder et al., 2012 ; Navarro et al., 2016). Par exemple, dans le domaine de la conduite, même lorsque des rappels incitent les conducteurs à rester attentifs, ceux-ci ne reprennent pas pleinement le contrôle et ne parviennent pas toujours à éviter un obstacle (Victor et al., 2018). Ce phénomène peut être transposé aux interactions avec l’IA : plus l’utilisateur se repose sur l’automatisation, moins il se sent responsable des décisions prises, ce qui peut entraîner une diminution de la vigilance et de l’ajustement des actions.

Perte de responsabilité

Une diminution du sentiment d’agentivité dans un contexte automatisé peut également rendre plus difficile l’attribution de la responsabilité des décisions prises. Lorsque l’IA occupe une place centrale dans le processus décisionnel, l’utilisateur peut avoir l’impression de ne plus être pleinement responsable, considérant la machine comme l’acteur principal des choix effectués. De leur côté, les concepteurs d’IA peuvent soutenir que leur système se limite à fournir une assistance et ne prend pas de décisions de manière autonome. Cependant, la plupart du temps, les concepteurs eux-mêmes n’ont pas accès aux mécanismes sous-jacents du modèle, en particulier dans le cas des algorithmes d’apprentissage profond, et ne peuvent donc pas expliquer avec précision comment une décision a été prise par l’IA. Nous avons abordé cet aspect dans un précédent article « Comprendre l’IA : pourquoi expliquer ses décisions est un défi ? ». Cette ambiguïté sur l’attribution de responsabilité soulève des questions juridiques et éthiques complexes, en particulier dans des domaines où les décisions assistées par l’IA ont un impact direct sur la vie des individus, comme la justice, la finance ou la médecine (Rahwan et al., 2019).

Manque d’acceptabilité

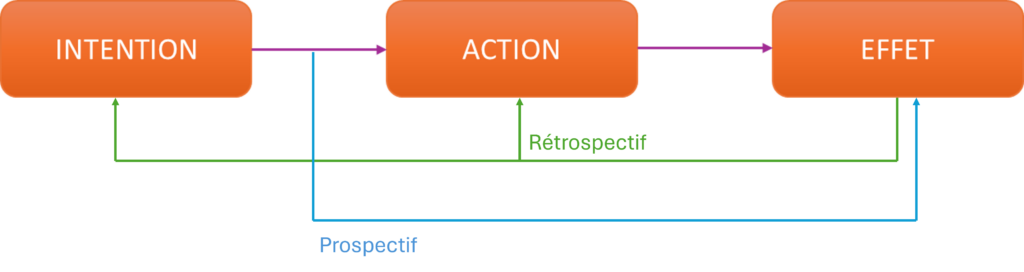

Une diminution du sentiment d’agentivité ne se répercute pas uniquement sur l’engagement de l’utilisateur ou sur l’attribution de la responsabilité ; elle peut aussi affecter l’acceptation même du système. Lorsqu’un utilisateur ne se sent pas en contrôle d’un système automatisé, il peut non seulement éprouver de la méfiance, mais aussi remettre en question la pertinence des décisions de l’IA. Cette perte de confiance affecte directement l’acceptabilité du système : même si une IA est fiable, efficace et utile, ces qualités ne suffisent pas à garantir qu’elle sera adoptée si l’utilisateur a le sentiment de ne pas maîtriser son fonctionnement (Shneiderman & Plaisant, 2004). En effet, l’acceptabilité des nouvelles technologies repose sur plusieurs facteurs, qui ont été étudiés en sciences cognitives et en ergonomie, notamment dans le Technology Acceptance Model (TAM) (Davis, 1989) et ses extensions par Venkatesh et al. (2012). Sans entrer dans le détail ici, la synthèse des travaux sur l’UTAUT (Unified Theory of Acceptance and Use of Technology) est présentée en (Fig. 2) et décrite précisément dans cet article « La théorie unifiée de l’acceptation et de l’utilisation de la technologie ».

Au-delà des critères d’utilité, d’efficacité et de fiabilité, qui sont généralement considérés comme fondamentaux pour l’acceptabilité d’un système, le sentiment d’agentivité ressenti par l’utilisateur est déterminant pour accepter une technologie. Une diminution de ce sentiment, en particulier dans les interactions avec des systèmes hautement automatisés, peut en effet constituer un frein majeur à l’acceptation de la technologie (Le Goff et al., 2018).

Face aux risques liés à la diminution du sentiment d’agentivité dans les interactions avec l’IA, il devient essentiel de repenser la manière dont ces technologies sont conçues et intégrées. Plusieurs solutions peuvent être envisagées pour tenter d’atténuer cette perte de contrôle perçue, et tenter de maintenir l’humain dans la boucle de contrôle.

Quelles solutions sont envisagées pour pallier cette baisse du sentiment d’agentivité ?

Pour pallier la diminution du sentiment d’agentivité lors des interactions avec l’IA, plusieurs pistes sont évoquées dans la littérature afin de favoriser une implication active des utilisateurs dans les processus décisionnels assistés par l’IA.

Explicabilité de l’IA

Du côté technique, l’une des principales pistes repose sur l’explicabilité des modèles d’IA, souvent désignée sous le terme de eXplainable AI (XAI). Celle-ci regroupe l’ensemble des méthodes visant à rendre plus compréhensibles les décisions algorithmiques, en expliquant les critères sur lesquels elles s’appuient. Ces explications visent à réduire l’opacité des systèmes, ce qui permet aux utilisateurs de mieux saisir les raisons qui sous-tendent les recommandations. Cela renforce leur capacité à les accepter, les contester ou les ajuster de manière éclairée. L’explicabilité répond également à des obligations réglementaires : l’IA Act européen impose, notamment pour les systèmes à haut risque, des exigences strictes de transparence, de traçabilité et de supervision humaine. Toutefois, la manière de formuler ces explications pour qu’elles soient réellement utiles reste une question ouverte, un sujet que nous approfondissons dans cet article « Comprendre l’IA : pourquoi expliquer ses décisions est un défi ? ».

Conserver l’implication de l’opérateur

D’un point de vue centré sur l’utilisateur, une autre approche consiste à maintenir un rôle actif dans l’interaction avec l’IA. Plutôt que de limiter l’humain à un rôle de validation passive, il s’agit de concevoir des systèmes qui l’invitent à ajuster, modifier ou contester les décisions proposées. Ce type de conception interactive rejoint le concept de « human-in-the-loop » où l’IA et l’utilisateur collaborent pour affiner la prise de décision (Wen et al., 2019). L’étude de Berberian et al. (2012) illustre cette dynamique : dans une tâche de supervision automatisée, les auteurs montrent que le sentiment d’agentivité diminue avec l’augmentation du niveau d’automatisation, mais qu’il est mieux préservé lorsque les utilisateurs peuvent intervenir sur les actions du système. Ces résultats soulignent l’importance de concevoir des systèmes interactifs qui intègrent l’utilisateur dans le processus décisionnel, afin de maintenir son engagement et sa responsabilité. En intégrant des mécanismes qui encouragent une participation active, ces systèmes soutiennent la perception de responsabilité et la capacité à se sentir à l’origine des décisions prises. Par exemple, dans le domaine du contrôle aérien, un système d’IA peut proposer des trajectoires optimisées pour les avions, mais celles-ci doivent être validées par l’opérateur humain à plusieurs étapes du processus : lors de la planification initiale, avant l’exécution de la manœuvre, et en cas d’ajustement en temps réel. Cette participation répétée renforce le sentiment d’être à l’origine des décisions, tout en permettant à l’utilisateur de garder un contrôle effectif sur l’action (Berberian et al., 2012).

Former et sensibiliser à l’IA

Enfin, maintenir le sentiment d’agentivité face aux décisions automatisées ne dépend pas seulement de la conception des systèmes ou de conserver une participation active, mais aussi de la formation et de la sensibilisation des utilisateurs. Par « formation », on entend ici des dispositifs visant à doter les utilisateurs de compétences minimales en matière de connaissances sur les algorithmes : comment une IA apprend, ce qu’elle optimise, ce qu’elle ne sait pas faire, et dans quelles conditions elle peut produire des erreurs. Il s’agit aussi d’apprendre à identifier les situations dans lesquelles une intervention humaine reste essentielle. Quant à la sensibilisation, elle renvoie à une capacité plus générale à reconnaître les limites des systèmes automatisés et à conserver une posture critique face à l’autorité perçue des systèmes. Avec la diffusion rapide des technologies d’IA générative comme ChatGPT, il devient essentiel de sensibiliser les utilisateurs à leur fonctionnement et à leurs limites. Une meilleure compréhension de ces outils permettrait d’encourager un usage réfléchi, fondé sur un regard critique et une intervention humaine là où elle reste nécessaire.

CONCLUSION

L’intégration croissante de l’IA dans nos processus décisionnels transforme profondément notre rapport à l’action et à la responsabilité. En apportant une assistance précieuse dans de nombreux domaines, ces technologies permettent d’améliorer l’efficacité et la rapidité de la prise de décision. Toutefois, elles soulèvent également des questions fondamentales sur le rôle de l’humain dans ces interactions. En particulier, il apparaît essentiel d’examiner comment l’IA modifie le sentiment d’agentivité, non pas uniquement sous l’angle de la délégation dans la prise de décision, mais en interrogeant les conditions qui permettent à l’individu de se percevoir comme l’agent de ses actions, tout en intégrant de manière réfléchie les apports informationnels de l’IA.

Les recherches montrent que plus un système est automatisé, plus l’utilisateur risque de se désengager du processus décisionnel. Cette perte de contrôle perçu peut conduire à une acceptation passive des recommandations de l’IA, voire à une dépendance excessive aux systèmes automatisés. Ce phénomène, bien documenté dans des domaines comme la médecine ou l’aviation, illustre un risque majeur : en réduisant l’implication des utilisateurs, l’IA peut affaiblir leur vigilance et leur esprit critique, ce qui compromet la qualité des décisions finales. À cela s’ajoute une incertitude sur la répartition des responsabilités : si un algorithme joue un rôle central dans la prise de décision, qui doit en assumer les conséquences ? L’utilisateur qui suit la recommandation, ou le concepteur du système qui l’a mis en place ? Ce flou juridique et éthique est d’autant plus préoccupant que certains systèmes d’IA, notamment ceux reposant sur l’apprentissage profond, fonctionnent comme des boîtes noires dont les mécanismes restent largement incompris, y compris par leurs propres créateurs.

Face à ces enjeux, plusieurs pistes ont été envisagées pour préserver l’agentivité des utilisateurs et garantir une interaction équilibrée entre l’humain et la machine. L’une d’elles repose sur la conception de systèmes favorisant une implication active de l’utilisateur. Offrir la possibilité d’ajuster, de modifier ou de contester les décisions algorithmiques permettrait de renforcer le rôle de l’humain dans le processus et d’éviter un glissement vers une délégation excessive. De même, l’explicabilité des modèles d’IA pourrait permettre aux utilisateurs de mieux appréhender les choix algorithmiques et de rester maîtres de la décision finale, en rendant ces systèmes plus transparents et compréhensibles.

Mais au-delà de la conception des systèmes, préserver l’agentivité face aux décisions automatisées passe aussi par la formation et la sensibilisation des utilisateurs. Comprendre comment fonctionne l’IA, ses limites et les biais qui influencent ses décisions est essentiel pour éviter une adoption passive et favoriser un usage éclairé. L’essor des technologies d’IA générative, comme ChatGPT, rend cette nécessité encore plus pressante : ces outils, désormais accessibles à tous, influencent profondément notre manière de rechercher de l’information, d’écrire ou de prendre des décisions. Il est donc essentiel d’encourager une approche critique et réfléchie, où l’IA est perçue comme un outil d’assistance, et non comme un substitut à la réflexion humaine.

RÉFÉRENCES

Berberian, B., Sarrazin, J.-C., Le Blaye, P., & Haggard, P. (2012). Automation technology and sense of control: A window on human agency. PLoS ONE, 7(3), e34075.

Chambon, V., and Haggard, P. (2013). “Chapter. 4 Premotor or ideomotor: how does the experience of action come about?,” in Action science foundation of an emerging discipline, eds W. Prinz, M. Beisert, and A. Herwig (Cambridge, MA: MIT Press), 359–380. doi: 10.7551/mitpress/9780262018555.001.0001

Davis, F. D. (1989). Technology acceptance model: TAM. Al-Suqri, MN, Al-Aufi, AS: Information Seeking Behavior and Technology Adoption, 205, 219.

Doshi-Velez, F., & Kim, B. (2017). Towards A Rigorous Science of Interpretable Machine Learning. arXiv preprint arXiv:1702.08608.

Endsley, M. R., & Kiris, E. O. (1995). The Out-of-the-Loop Performance Problem and Level of Control in Automation. Human Factors, 37(2), 381-394. https://doi.org/10.1518/001872095779064555

Goddard, K., Roudsari, A., & Wyatt, J. C. (2012). Automation bias: a systematic review of frequency, effect mediators, and mitigators. Journal of the American Medical Informatics Association : JAMIA, 19(1), 121–127. https://doi.org/10.1136/amiajnl-2011-000089

Haggard, P., & Chambon, V. (2012). Sense of agency. Current Biology, 22(10), R390-R392.

Le Goff, K., Rey, A., Haggard, P., Oullier, O., and Berberian, B. (2018). Agency modulates interactions with automation technologies. Ergonomics 61, 1282–1297.

Miller, T. (2019). Explanation in artificial intelligence: Insights from the social sciences. Artificial Intelligence, 267, 1-38.

Mulder, M., Abbink, D. A., and Boer, E. R. (2012). Sharing control with haptics: seamless driver support from manual to automatic control. Hum. Fact. 54, 786–798. doi: 10.1177/0018720812443984

Navarro, J., François, M., and Mars, F. (2016). Obstacle avoidance under automated steering: Impact on driving and gaze behaviours. Transp. Res. Part F Traffic Psychol. Behav. 43, 315–324. doi: 10.1016/j.trf.2016.09.007

Rahwan, I., Cebrian, M., Obradovich, N., Bongard, J., Bonnefon, J. F., Breazeal, C., … & Wellman, M. (2019). Machine behaviour. Nature, 568(7753), 477-486.

Shneiderman, B., & Plaisant, C. (2004). Designing the user interface: Strategies for effective human-computer interaction.

Skitka, L. J., Mosier, K. L., & Burdick, M. (1999). Does automation bias decision-making?. International Journal of Human-Computer Studies, 51(5), 991-1006.

Venkatesh, V., Thong, J. Y., & Xu, X. (2012). Consumer acceptance and use of information technology: extending the unified theory of acceptance and use of technology. MIS quarterly, 157-178.

Victor, T. W., Tivesten, E., Gustavsson, P., Johansson, J., Sangberg, F., and Ljung Aust, M. (2018). Automation expectation mismatch: incorrect prediction despite eyes on threat and hands on wheel. Hum. Fact. 60, 1095–1116. doi: 10.1177/0018720818788164

Wen, W., Kuroki, Y., and Asama, H. (2019). The sense of agency in driving automation. Front. Psychol. 10:2691. doi: 10.3389/fpsyg.2019.02691