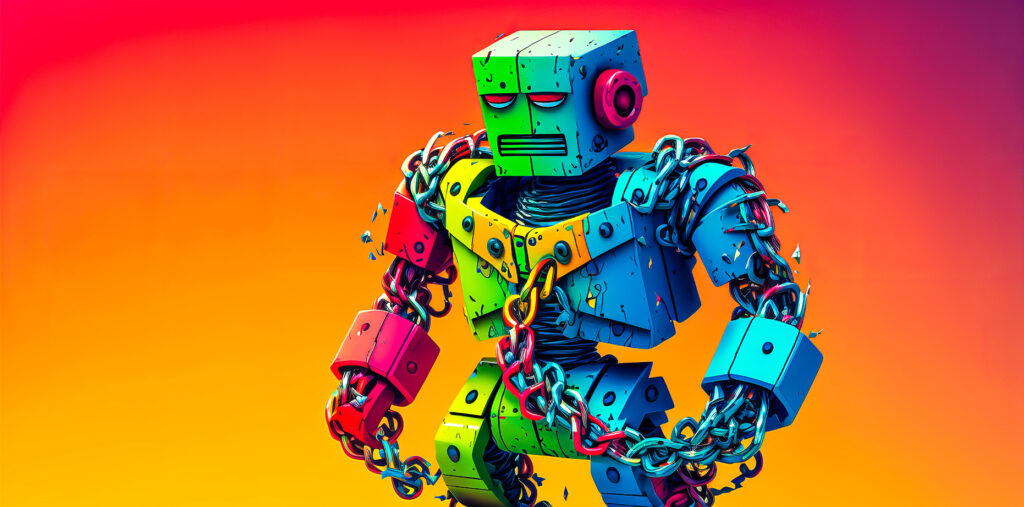

L’utilisation de l’Intelligence Artificielle dans le processus de recrutement : une méthode sans risques ?

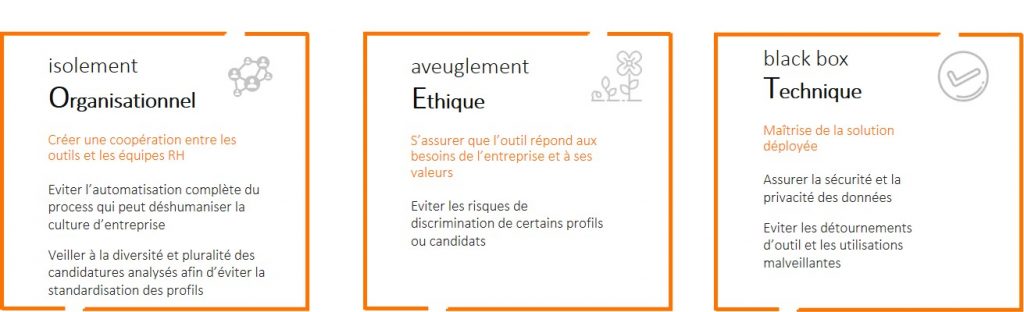

L’IA dans le recrutement apporte un gain de temps et mobilise les RH sur des actions à forte valeur ajoutée. Allier l’action de l’IA et des recruteurs garantit la maîtrise des outils et évite des résultats indésirables, comme le risque de discrimination.

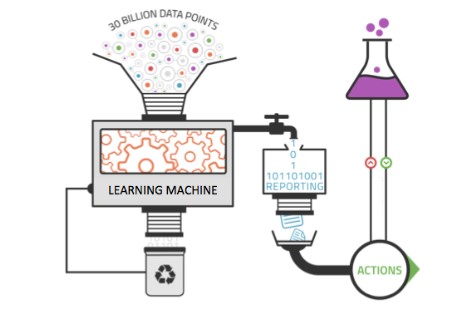

Plus les données injectées à un système de machine learning sont nombreuses, plus l’IA apprend et devient précise. En revanche, si les données ne sont pas suffisantes ou non représentatives, cela peut conduire à des conséquences inattendues ou des résultats non désirés..

L’IA et les technologies associées comme les chatbots, présentent de nouveaux risques en matière de cybersécurité. Ils doivent être anticipés afin d’éviter des failles ou détournement des outils, et afin de garantir la protection et la privacité des données.

Depuis quelques années, les entreprises françaises s’intéressent à l’intelligence artificielle et à la manière de l’intégrer au sein des directions de ressources humaines. Ainsi, selon une étude du cabinet de conseil Gartner, 23% des projets actuellement menés par les organisations autour de l’IA concerne la gestion des ressources humaines et le recrutement.

Cette technologie, qui présente de nombreux avantages notamment pour les processus de sourcing et d’échange avec les candidats nécessite un déploiement maîtrisé qui réponde aux besoins et impératifs de l’entreprise.

A défaut, l’absence de maîtrise des outils d’IA peut faire émerger des conséquences allant à l’encontre des intérêts de l’entreprise. Dans cet article, nous analysons certains impacts indésirables liés au déploiement d’outils d’IA dans les ressources humaines, afin de rendre explicite des risques que les organisations devraient considérer afin de les éviter.

La phase de sourcing et ses risques

Le cas d’usage le plus fréquent de l’IA dans le processus de recrutement concerne l’acquisition de talents, principalement lors de la phase de sourcing (identification/pré-sélection de candidats) et prises de rendez-vous, notamment dans les organisations qui ont des volumes importants de postes à pourvoir. Cependant, lorsque l’intelligence artificielle est utilisée pour identifier, analyser et pré sélectionner des candidats parmi des milliers de CV reçus, deux impacts indésirables doivent être considérés, liés à l’automatisation complète du recrutement :

- La déshumanisation du process et donc la perte de sens de ce qui est ‘exception’ ou hors norme

- La standardisation non désirée des profils recrutés.

Lors de la phase de sourcing, l’ensemble des tâches peut être délégué à l’IA. Cela permet notamment aux recruteurs d’éviter un travail répétitif et fastidieux (collecte et analyse des CV, pré-sélection de candidats) et ainsi de se concentrer sur des actions à plus forte valeur ajoutée (rencontre et évaluation de candidats). Cette mécanisation/robotisation du processus est un gain de temps évident pour l’entreprise.

Cependant cette démarche peut entraîner la déshumanisation du processus de recrutement lorsqu’on perd la notion de contact entre les candidats et l’organisation. Cela serait sans risque si tous les profils et candidatures répondaient à un même standard. Mais dès lors que l’enjeux pour les RH est de détecter des profils spécifiques, ou d’identifier le potentiel dans un parcours non linéaire, l’automatisation pure peut s’avérer contreproductive. Un candidat pourra se voir refuser un poste sans avoir rencontré un seul collaborateur de l’entreprise, et ceci pour des raisons non pas en lien avec ses compétences, mais plutôt avec le ‘format de lecture’ de sa candidature.

Pour éviter une déshumanisation complète en phases de sourcing et screening des candidatures, certaines entreprises allient l’IA et l’homme dans leur processus. L’entreprise Randstad, par exemple, s’est dotée au niveau national, depuis février 2019, d’un chatbot ou agent conversationnel dédié au recrutement. Ce chatbot a été programmé pour simuler une conversation en langage naturel afin de détecter le potentiel des candidats susceptibles de convenir au mieux au poste proposé. Randy pré-qualifie les candidats à l’aide d’une série de questions et leur attribue une note à l’issue de l’interaction. Les personnes ayant reçu un score élevé seront recontactées par un collaborateur de Randstad et la suite du processus de recrutement se poursuivra avec lui.

Le cas de Randstad montre l’effort fait par certaines organisations pour créer une complémentarité entre l’IA et les recruteurs. Cette relation permet de fluidifier le traitement de candidatures, faciliter le processus de recrutement et laisser l’espace aux professionnels des ressources humaines pour un traitement plus qualitatif des candidats. On évite ainsi une automatisation complète qui pourrait être perméable à certains profils ou types de candidature.

Ainsi, comme les organisations cherchent à détecter le potentiel dans des profils spécifiques parmi le volume de candidats, elles cherchent également à éviter la standardisation des recrutements. Dans un contexte d’automatisation croissante de tâches récurrentes et de recherche de la valeur ajoutée, les recruteurs prêtent une importance particulière aux « softs skills » et au savoir-être des candidats, compétences autant valorisées que leurs connaissances techniques et académiques. Cela permet notamment d’attirer des profils atypiques mais qui présentent un réel potentiel.

Des outils d’intelligence artificielle sont en mesure de détecter les « softs skills » des candidats, comme InstarLink ou CVCatcher. Lors des analyses de CVs, ces solutions prennent en compte non seulement les connaissances académiques des candidats, mais également leurs intérêts, aspirations ainsi que leurs connaissances comportementales. Ces dernières sont classées par niveau d’importance en fonction du métier recherché.

Cependant, tous les outils de recrutement utilisant l’IA ne sont pas encore paramétrés de cette manière et ne peuvent donc pas détecter le savoir-être des candidats. Les outils les plus déployés aujourd’hui fonctionnent avec des algorithmes qui analysent les compétences techniques et académiques des candidats. Cela s’explique par le fonctionnement même de ce type d’algorithme qui effectue des recherches par mots clés selon le poste à pourvoir et sur la base de l’existant (profils types présents dans la société).

La recherche par mots-clés se fait alors sur des éléments historiques concrets, comme des performances académiques, des expériences, des formations ou des compétences techniques. Dans ce cas, il est donc important de considérer l’IA comme un outil complémentaire dans le processus de recrutement, tout en conservant un contact humain afin d’éviter le recrutement de profils similaires, sans aucune diversité qui pourraient amener à une standardisation des candidats.

L’intelligence artificielle, possible source de discrimination ?

Beaucoup espèrent, par ailleurs, que l’intelligence artificielle aidera les décideurs à éviter leurs propres préjugés en ajoutant de la cohérence au processus d’embauche. Selon Sonia Sedler, Directrice Europe Moyen Orient et Afrique de Sutherland, société de conseil en transformation digitale, l’IA n’a aucun préjugé inhérent, et dans sa forme la plus pure peut éliminer les préjugés inconscients du processus de recrutement.

Cependant, l’IA ne fait que reproduire puisqu’elle repose sur une modélisation construite à partir de données réelles à un moment donné appelé algorithme. Un algorithme se fonde sur deux principes importants : l’intégration de nombreuses données diverses et changeantes d’une part, et une analyse et un apprentissage des modèles transmis d’autre part.

En revanche, si les données intégrées dans l’outil ne sont pas suffisantes, non représentatives de la réalité ou des résultats espérés, cela peut conduire, à terme, à des conséquences inattendues ou à des résultats non désirés. Le risque peut être, en effet, que l’algorithme reproduise les biais institutionnels ou historiques de l’organisation, amplifiant les désavantages pour certains profils et pouvant conduire à la discrimination, volontaire ou pas, de certains candidats.

L’exemple de la solution d’IA d’Amazon pour le recrutement illustre bien les effets indésirables d’un apprentissage non maîtrisé de l’algorithme. Amazon a dû arrêter l’utilisation de son nouvel outil de recrutement après avoir découvert que le système mis en place montrait des préjugés sexistes à l’égard des femmes. L’algorithme exploité par Amazon, utilisait le « machine learning », se basant sur des données préexistantes pour prendre des décisions.

Ainsi l’outil avait été entrainé avec les profils des collaborateurs de l’entreprise des 10 dernières années, profils principalement masculins. L’algorithme avait donc développé un biais afin de préférer les candidats masculins, et les CVs contenant le terme « femme » étaient par exemple pénalisés. Les équipes d’Amazon ont mis plus d’un an à détecter cette discrimination, ce qui a produit des effets non désirés aussi bien dans leur process de recrutement que sur l’image de l’entreprise.

Le risque de discrimination est d’autant plus important lorsque les algorithmes sont développés par des entreprises externes, et utilisés par des organisations qui n’ont pas, pour la plupart, la possibilité ou les compétences en interne pour comprendre comment ils sont construits. Selon Kurt Heikkinen, président de Montage, société qui propose une solution informatique destinée au recrutement, « les entreprises doivent adopter une approche prudente lors de la mise en œuvre de l’IA et s’assurer que la technologie est éprouvée et validée ». Une gestion appropriée, accompagnée de sensibilisation et formation des différents services d’une entreprise, dont le département RH, sont nécessaires pour anticiper et éviter le type d’écueils présentés ci-dessus.

L’IA versus cybersécurité

Enfin, l’intelligence artificielle et les technologies associées qui en découlent présentent également de nouveaux risques en matière de cybersécurité.

Cela concerne principalement la sécurité numérique et notamment la protection des données personnelles. D’une part, l’automatisation des tâches pourrait augmenter les menaces associées aux cyberattaques tel que le phishing (ou hameçonnage) par e-mail. L’utilisation de l’intelligence artificielle ne ferait que démultiplier le risque car cela pourrait entrainer des attaques à grand échelle, mieux ciblées et plus convaincantes.

Cyxtera Technologies, entreprise américaine de cybersécurité, a d’ailleurs voulu montrer cela en créant des adresses Web d’hameçonnage à l’aide d’un logiciel de machine learning généré par l’intelligence artificielle. Ces adresses Web, qui prenaient l’apparence de pages d’identification de sites web existants, étaient en mesure de récupérer les identifiants des utilisateurs floués sans détection possible des systèmes de défense actuels. Ce cas démontre bien que la sécurisation des données doit rester au cœur des préoccupations des entreprises, y compris pour les données des candidats et des collaborateurs.

D’autre part, certaines technologies comme les chatbots, utilisés notamment pour le recrutement, pourraient faire l’objet de détournements. Se faisant passer par le chatbot, des hackers sont en mesure d’exploiter les failles de certains systèmes, ou conduire à des usages malveillants (usurpation d’identités). Les agents conversationnels peuvent être amenés à collecter et analyser de nombreuses données personnelles des utilisateurs, et le risque que certaines données sensibles soient utilisées de façon malveillante par certains individus ou entreprises n’est pas exclu. La réglementation générale sur la protection des données a d’ailleurs été mise à jour en 2018 pour exiger aux entreprises de montrer qu’elles sont capables de protéger toutes les données collectées. La difficulté est d’ailleurs grandissante, car le volume de données ne cesse de croître, amplifié par l’arrivée de nouvelles technologies (comme les chatbots).

Ainsi, pour que leur projet de mise en conformité sur la protection des données soit réussi et efficace, les entreprises devront s’entourer des meilleurs experts (juridique, technologique). L’ampleur est telle qu’un groupe d’experts a été créé en juin 2018 au niveau européen. Baptisé High Level Group on Artificial Intelligence (AI HLG), ce comité de 52 membres compétents en matière de protection et privacité des données, sera notamment chargé d’élaborer un projet de lignes directrices sur l’éthique, en matière d’équité, de sécurité et de transparence.

À ce jour, l’intelligence artificielle propose clairement une nouvelle vision du recrutement au sein des organisations. Tous les risques identifiés ci-dessus peuvent être minimisés. Pour cela, il est nécessaire de connaître la technologie, définir ses besoins afin d’identifier les bons outils, et connaître les risques pour être en mesure de les anticiper.

Ainsi, l’utilisation des nouvelles technologies dans les processus de recrutement peut apporter des gains d’efficacité et de performance certains à l’entreprise, à condition d’en faire une utilisation maîtrisée pour prendre la mesure de l’importance et des enjeux qui découlent de son utilisation. Mise en conformité et fiabilisation de la solution, anticipation des réglementations à venir et sécurisation des données ne sont donc qu’une question de temps pour que les organisations se mettent à jour et limitent les risques évoqués. Même si l’action humaine semble indispensable dans les processus de recrutement, l’intelligence artificielle aura, dans les prochaines années, un impact certain sur le métier de recruteur.

Pour aller plus loin